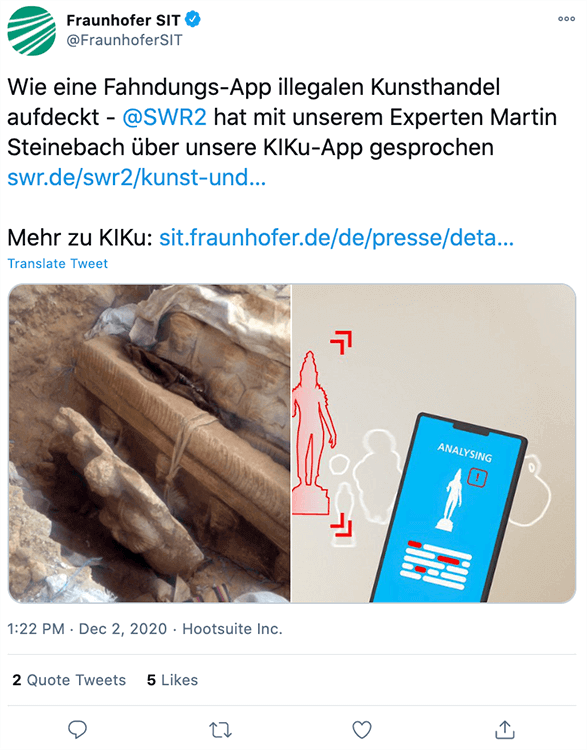

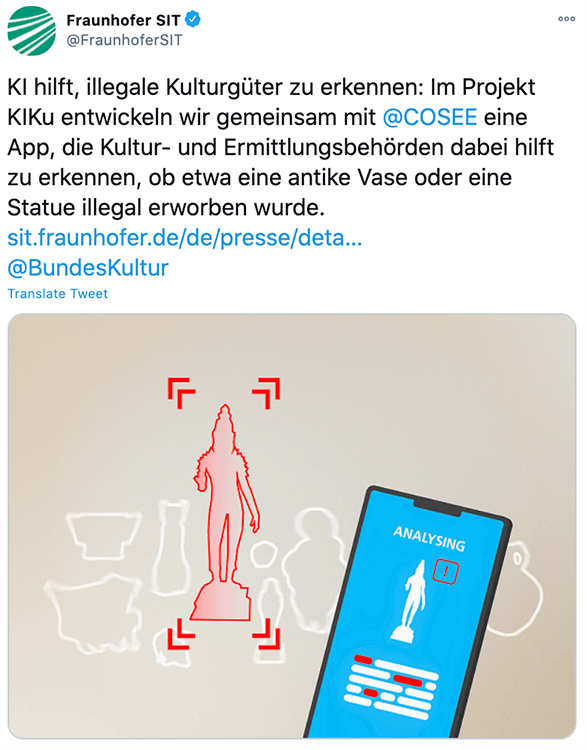

Das Fraunhofer SIT und cosee helfen Ermittlern, Kunstwerke mittels KI zu erkennen

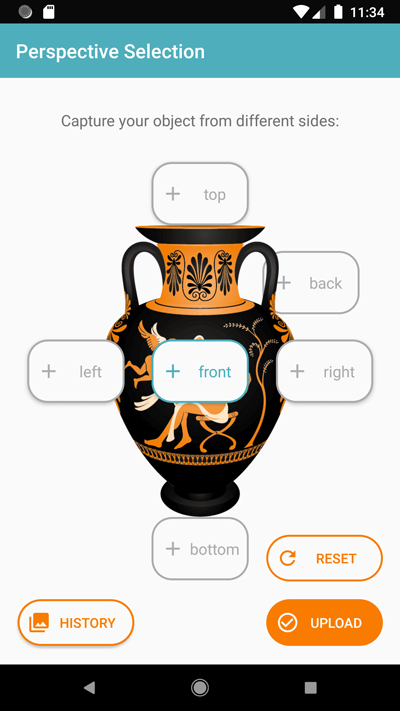

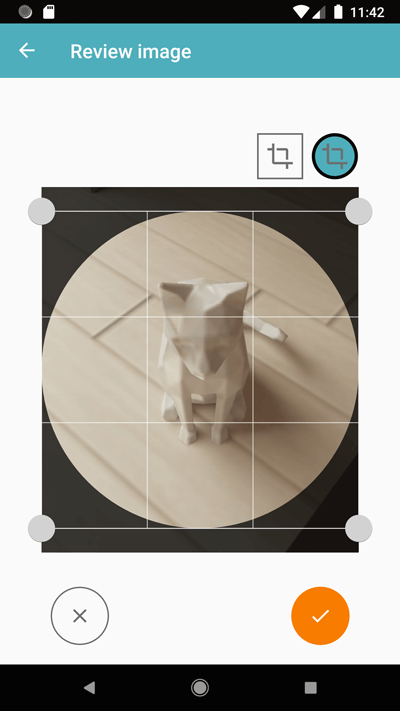

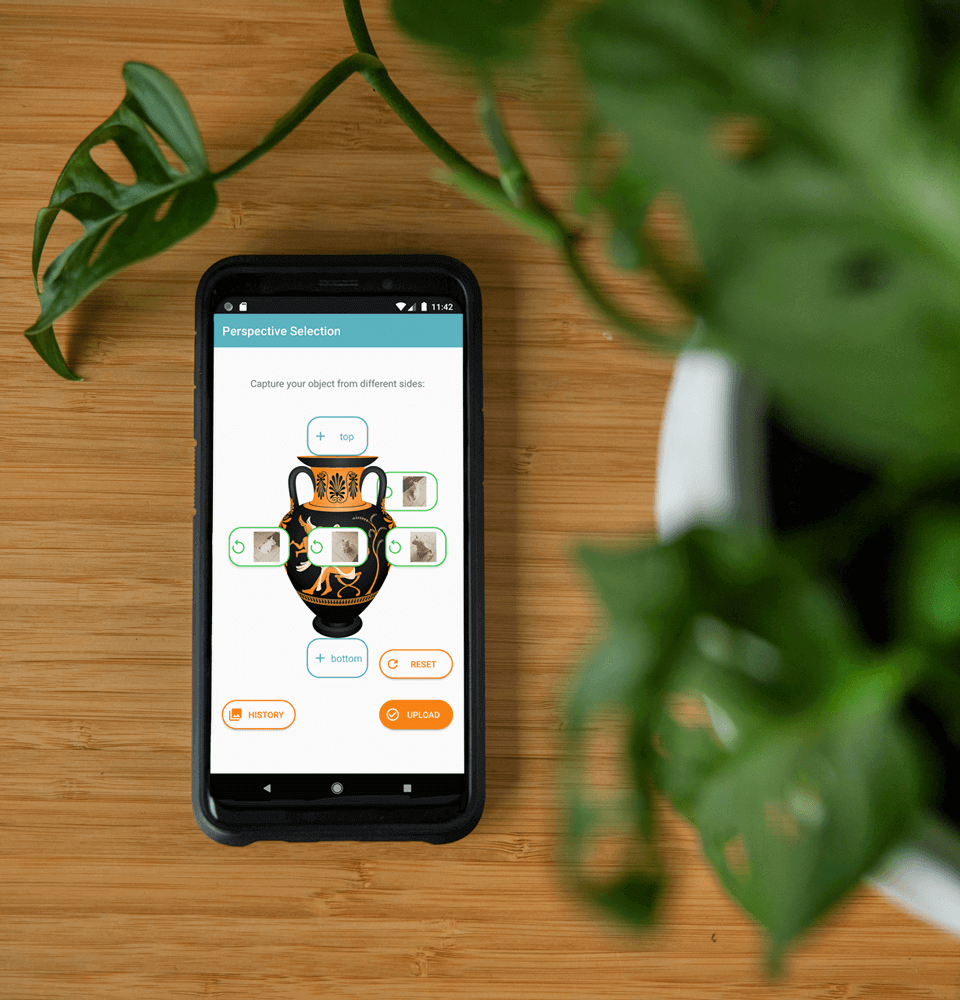

KIKU – Kunstexpertise für die Hosentasche

Kulturgüter wie antike Münzen, Vasen, Figuren, Waffen und Fossilien werden immer wieder gestohlen und geschmuggelt. Oft passiert der Diebstahl in Form von Raubgrabungen direkt an den historischen Stätten. Damit sind die Güter nirgendwo durch einen Experten erfasst worden. Gleichzeitig sind diese Güter für einen Beamten beim Zoll oder bei der Polizei nur schwer zu erkennen und von legalen Objekten zu unterscheiden. Das Fraunhofer SIT als Projektpartner und cosee kombinieren ein Deep-Learning-Netz und eine App, um dieses Problem zu lösen.

Kontaktiert uns!